KI-Serie: Wie Maschinen lernen, Gefühle zu erkennen

18.02.2019, 05:54 Uhr

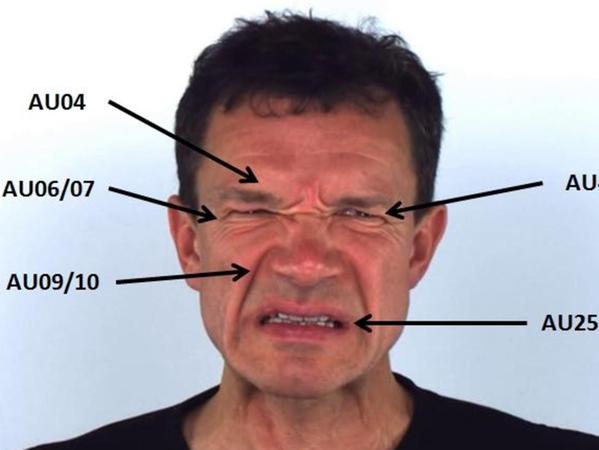

Die Menschen auf den Videos kneifen die Augenbrauen zusammen. Sie kräuseln die Nase, manche schließen die Augen. Diese Probanden leiden Schmerzen, und das sieht man ihnen an. Für die Wissenschaft erdulden sie schmerzhaften Druck auf Muskeln am Halsansatz oder einen unangenehmen Hitzereiz. Natürlich sind die Tests freiwillig und die Schmerzen "im Rahmen", versichert Jens-Uwe Garbas, Leiter Intelligente Systeme am Fraunhofer-Institut für integrierte Schaltungen in Erlangen. Aber die kleinen Quälereien sind nötig, um realistisches Material zu bekommen: Videoaufnahmen von menschlichen Gesichtern, die echte Schmerzen widerspiegeln. Sie sind das Futter für einen besonderen Algorithmus, den "Pain Face Reader".

Die Gesichtserkennungssoftware ist ein gemeinsames Projekt der Bamberger Informatikerin Ute Schmid (siehe Interview Seite 3), des Bamberger Biopsychologen Stefan Lautenbacher und Garbas’ Arbeitsgruppe am Fraunhofer-Institut. Das Ziel: Ein Computer soll selbstständig erkennen, ob ein Mensch Schmerzen leidet oder nicht. "Bei der Entwicklung künstlicher Intelligenz wird oft die kognitive Seite betrachtet, also die Frage: wie löst ein Computer ein Problem", sagt Garbas. "Wir untersuchen dagegen, wie Maschinen Emotionen erkennen können."

Kommentar: KI kann helfen, birgt aber auch viele Gefahren

Ein Computer mit Kamera, der die Pein in menschlichen Gesichtern detektieren kann, wäre ein Segen für Menschen, die sich nicht selbst mitteilen können, wie Demente oder Neugeborene. Sie müssten, wenn über ihren Zustand nicht mehr nur gemutmaßt wird, weniger unerkannte Schmerzen ertragen, glauben die Wissenschaftler.

Schmerz oder Ekel?

Doch die Voraussetzung für ein solches System ist, dass die Software ein besseres Gespür für mimische Schmerzanzeichen entwickelt als ein geschulter menschlicher Beobachter. "Die größte Herausforderung ist, dass Menschen zum Teil nur sehr subtil auf Schmerzen reagieren und auch sehr unterschiedlich", erklärt Garbas. Damit der Algorithmus Sicherheit gewinnt, braucht es vor allem "Trainingsmasse": so viele Videos wie möglich. Auf den Gesichtern der Freiwilligen wird jede Regung zwischen Kinn und Stirn vermessen und als sogenannte "Action Unit" (AU) erfasst. Mehr als 40 solcher AUs sind in der Psychologie zur Beschreibung menschlicher Mimik definiert; die Kontraktion der Augenbrauen gehört dazu, das Öffnen der Lippen oder ein Zwinkern.

"Auch kleine Unterschiede im zeitlichen Ablauf der einzelnen AUs sind wichtig", sagt Garbas. "Dadurch lässt sich Schmerz von anderen Emotionen wie Ekel oder Ärger abgrenzen." Schon jetzt sind solche Software-Lösungen dem Menschen in Teilen überlegen. "Es gibt Algorithmen, die können gestellte besser von echten Schmerzen unterscheiden als Menschen", berichtet Garbas.

Deep Learning, Cyborg und Blockchains: Glossar zu Künstlicher Intelligenz

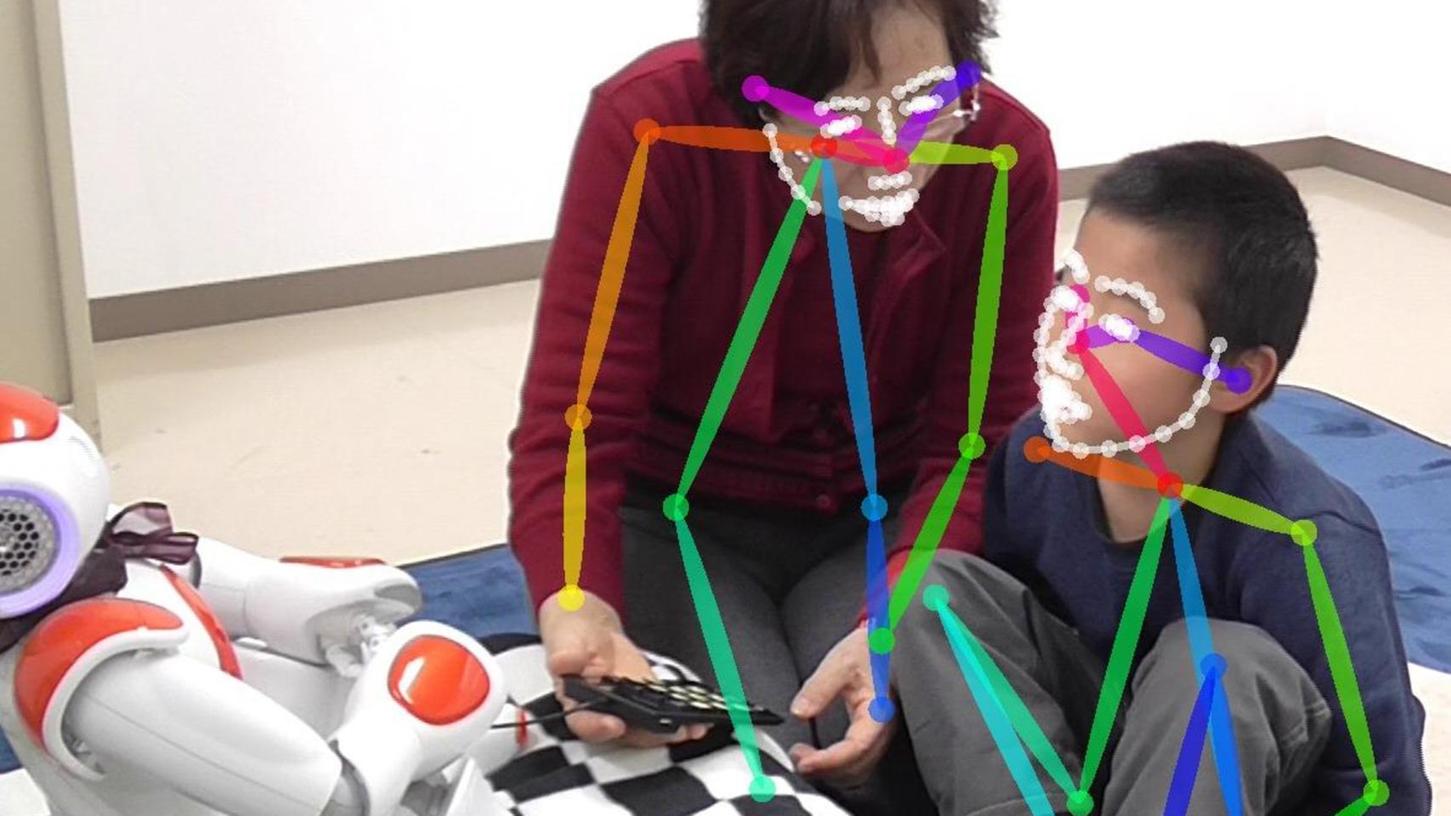

Auch bei Björn Schuller von der Universität Augsburg sitzen sich Mensch und Maschine gegenüber und feilen an Mimik, Sprache und Gestik. Im "EngageMe"-Projekt lässt der Professor für Informatik humanoide Roboter mit autistischen Kindern spielen, die Mimik und Stimmlage eines Gesprächspartners schwer einschätzen können und eigene Emotionen auf oft unverständliche Weise zeigen.

Kind und Roboter lernen

Roboter Nao lässt sich davon nicht verunsichern – und trifft bei seinen Trainingspartnern einen Nerv. "Autistische Kinder sind in der Regel technikaffin und lieben kontrollierbare Systeme", sagt Schuller. "Die Emotionen, die der Roboter zeigt, sind für sie leichter einzuschätzen als die eines Menschen." Auch die Roboter lernen im Training, atypische Äußerungen oder Gesten ihres Gegenübers richtig zu deuten und Feedback zu geben, wie sich Freude oder Ärger besser ausdrücken lassen. "Der Roboter plaudert mit dem Kind beispielsweise über seinen Tagesablauf und übt mit ihm, die jeweiligen Gefühle angemessen zu zeigen", erklärt Schuller.

Der "Pain Face Reader" und "EngageMe" sind Vorboten einer Welt, in der Mensch und Maschine emotional stärker miteinander verstrickt sind: Pflegeroboter müssen adäquat auf den Zustand ihres Patienten reagieren, selbstfahrende Autos die Gefühle ihrer Insassen bewerten können. Oder wie Jens-Uwe Garbas es zusammenfasst: "Bei jeder Mensch-Maschine-Interaktion ist es in Zukunft hilfreich, wenn die Maschine weiß, wie der Mensch sich fühlt."

Algorithmen stecken überall in unserem Alltag: Auto-Navigationssysteme ermitteln damit den kürzesten oder schnellsten Weg von A nach B. Ob und wie lange Ampeln Rot, Gelb oder Grün zeigen, wird mit Algorithmen berechnet. Darin fließen die Tageszeit oder die durch Induktionsschleifen im Boden gemessene Anzahl der Fahrzeuge ein.

Ein Algorithmus ist eine Abfolge von Schritten zur Lösung eines Problems. Eine mathematische Formel wie V = S / T zur Berechnung der Geschwindigkeit (V) aus der Eingabe von Strecke (S) und Zeit (T) ist ein einfacher Algorithmus. Suchmaschinen wie Google und soziale Netzwerke wie Facebook nutzen komplexere Algorithmen als diesen, etwa um zu entscheiden, welche Inhalte uns als Ergebnis einer Suche angezeigt werden oder welche Werbung direkt daneben ausgespielt wird.

Dahinter stecken Programme, die berücksichtigen, in welchem Land der Suchbegriff eingetippt wird, welches Betriebssystem auf dem Computer oder dem Smartphone läuft und welcher Browser benutzt wird. Oder nach welchen Begriffen der Internetnutzer zuvor gesucht und welche anderen Seiten er kürzlich angeschaut hat.

Wer also gerade online einen Flug gebucht hat, bekommt mit großer Wahrscheinlichkeit anschließend Werbung für Hotels angezeigt. Mitunter auch dann noch, wenn die Reise schon längst wieder vorbei ist — das ist ein Beispiel für schlecht funktionierende Algorithmen.

2 Kommentare

Um selbst einen Kommentar abgeben zu können, müssen Sie sich einloggen oder sich vorher registrieren.

0/1000 Zeichen